Wie sich KI durch gezielte Angriffe austricksen lässt

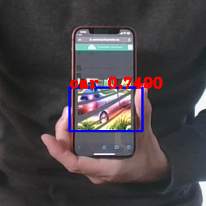

Ein buntes Fraunhofer-Logo auf einem Smartphone wird als Auto klassifiziert (siehe Abbildung 1). Mit unserem Angriff haben wir gezeigt, wie einfach es ist, KI-basierte Erkennungsverfahren so zu manipulieren, dass sie Objekte erkennen, wo physisch keine sind. Eine Täuschung, die zum Beispiel im Straßenverkehr erhebliche Konsequenzen haben kann. Diese sogenannten „Creation Attacks“ funktionieren mit beliebigen Objekten und lassen sich vor menschlichen Beobachtern verstecken. Anwendung finden unsere Erkenntnisse bereits im Rahmen des Fraunhofer-Cluster of Excellence Cognitive Internet Technologies CCIT im Projekt SmartIO zur Verbesserung einer intelligenten Straßenkreuzung.

Abbildung 1: Ein buntes Fraunhofer-Logo auf einem Smartphone wird als Auto klassifiziert.

Angriffe von innen und außen

Wie ist das Team hierbei vorgegangen? Schon seit einigen Jahren beschäftigen wir uns mit sogenannten „Adversarial Examples“. Dies sind präperierte Bilder oder Audiodateien mit speziellen Eigenschaften, die KI-Algorithmen zu falschen Klassifkationen verleiten. Ein menschlicher Beobachter nimmt diese Veränderungen der Bild- und Audiodateien meist gar nicht wahr – die KI jedoch erkennt genau das, was die Angreifenden sie erkennen lassen möchten.

In ihrer ursprünglichen Variante konnten diese Angriffe nur durchgeführt werden, wenn die Eingabe, also zum Beispiel das manipulierte Bild, direkt an den Computer übergeben wurde. Die neue Generation der Angriffe ist umso realistischer, da sie auch aus der Ferne, also auch über die Bilder einer Kamera, funktionieren. Einen solchen Angriff, in der Fachsprache „Physical Adversarial Attack“genannt, haben wir nun verfeinert. Hierbei haben wir, aufbauend auf Arbeiten internationaler Forschenden [1,2,3], einen Ansatz weiterentwickelt, mit welchem die Angriffe robuster werden.

Abbildung 2: Ein sogenanntes „Adversarial Example“ ist verleitet KI-Algorithmen zu falschen Klassifkationen.

Algorithmus analysiert neuronales Netz

Technisch wird ein Algorithmus verwendet, der das neuronale Netz zur Objekterkennung genau analysiert. Mittels Gradienten-basierter Verfahren kann nachvollzogen werden, wie die Eingabe angepasst werden muss, um das zugrundeliegende neuronale Netz zu täuschen. Im Optimierungsprozess haben wir ein Bild erstellt, das für die KI aussieht wie aus der Klasse des Zielobjekts. Dies führt zu hohen Erkennungsraten, selbst dann, wenn physisch gar kein Objekt vorliegt. Um die Angriffe vor menschlichen Beobachtern zu verstecken, haben wir zusätzlich berücksichtigt, dass die Manipulationen nur in einem bestimmten Bereich stattfinden dürfen, im dargestellten Beispiel also nur im Bereich des Fraunhofer-Logos. Da wir während der Erstellung des Angriffsmusters äußerliche Veränderungen wie Lichteinfall und Farbveränderungen simuliert haben, funktioniert der Angriff auch in der „echten Welt“ zuverlässig. Im Generierungsprozess haben wir die Eingabe iterativ erneuert: In jedem Schritt wird der Angriff so optimiert, dass er in verschiedenen Szenarien und unter diversen Transformationen seine Funktion behält.

Dasselbe Vorgehen funktioniert auch für andere Zielobjekte: So kann das bunte Logo statt zu einem Auto auch zu einer Fußgängerin oder einem Straßenschild werden.

Und wieso ist das relevant? Angriffe dieser Art können beispielsweise kritische Auswirkungen auf die Sicherheit autonomer Fahrzeuge haben: Angreifende können z.B. das Fahrverhalten eines anderen Autos beeinflussen, wenn sie mit dem Bild auf einem Smartphone die Objekterkennung im Fahrzeug austricksen.

Forschungsbedarfe erkennen und Angriffe abwehren

Mit unserem konkreten Anwendungsbeispiel wollen wir auf den weiteren Forschungsbedarf für diese Technologien aufmerksam machen. Im Forschungsprojekt SuKI werden neben der Anwendung im autonomen Fahrzeug noch weitere Einsatzfelder untersucht. Ein weiterer Fokus des Projekts liegt beispielsweise auf dem Einsatz von künstlicher Intelligenz in Spracherkennunssystemen oder bei der Zugangskontrolle. Insbesondere beschäftigen wir uns auch damit, wie derartige Angriffe abgewehrt werden können, indem wir KI-Verfahren robust gegenüber solchen Angriffen gestalten. Die entsprechenden Forschungsergebnisse wurden bereits auf hochrangigen Konferenzen präsentiert [4-7].

[0] REDMON, Joseph; FARHADI, Ali. Yolov3: An incremental improvement. arXiv preprint arXiv:1804.02767, 2018.

[1] CHEN, Shang-Tse, et al. Shapeshifter: Robust physical adversarial attack on faster r-cnn object detector. In: Joint European Conference on Machine Learning and Knowledge Discovery in Databases. Springer, Cham, 2018. S. 52-68.

[2] ATHALYE, Anish, et al. Synthesizing robust adversarial examples. In: International conference on machine learning. ICML, 2018. S. 284-293.

[3] CARLINI, Nicholas; WAGNER, David. Towards evaluating the robustness of neural networks. In: 2017 ieee symposium on security and privacy (sp). IEEE, 2017. S. 39-57.

[4] SCHULZE, Jan-Philipp; SPERL, Philip; BÖTTINGER, Konstantin. DA3G: Detecting Adversarial Attacks by Analysing Gradients. In: European Symposium on Research in Computer Security. Springer, Cham, 2021. S. 563-583.

[5] SPERL, Philip; BÖTTINGER, Konstantin. Optimizing Information Loss Towards Robust Neural Networks. arXiv preprint arXiv:2008.03072, 2020.

[6] DÖRR, Tom, et al. Towards resistant audio adversarial examples. In: Proceedings of the 1st ACM Workshop on Security and Privacy on Artificial Intelligence. 2020. S. 3-10.

[7] SPERL, Philip, et al. DLA: dense-layer-analysis for adversarial example detection. In: 2020 IEEE European Symposium on Security and Privacy (EuroS&P). IEEE, 2020. S. 198-215a

Weiterführende Informationen

Autoren

Karla Pizzi

Karla Pizzi arbeitete nach einem Studium in Mathematik, Politikwissenschaft und Informatik als wissenschaftliche Mitarbeiterin am Fraunhofer AISEC. In der Forschungsabteilung Cognitive Security Technologies beschäftigte sie sich aktuell vornehmlich mit Adversarial Examples, um Systeme der Künstlichen Intelligenz vor Manipulation zu schützen.

Jan-Philipp Schulze

Jan-Philipp Schulze hat an der ETH Zürich Elektrotechnik und Informationstechnologie studiert und war als wissenschaftlicher Mitarbeiter am Fraunhofer AISEC tätig. Sein Forschungsschwerpunkt in der Forschungsabteilung Cognitive Security Technologies lag auf Anomalie-Erkennung und Adversarial Machine Learning.

Kontakt: presse@aisec.fraunhofer.de